初めまして。CTO室リサーチャーの野元です。

モルフォでは最先端の画像処理・機械学習に関する研究のキャッチアップのため、国内外問わず毎年各種学会に技術系の社員を派遣しています。今回は ICML 2020(International Conference on Machine Learning 2020)にCTO室リサーチャーの川邉とともに参加しました。

今回は学会の概要と私が注目した発表3件についてご紹介します。 後編では「Evaluating Machine Accuracy on ImageNet」等について川邉から報告する予定です。

ICML 2020 概要

ICML 2020(International Conference on Machine Learning 2020)は機械学習のトップカンファレンスの一つです。第37回目となる今年はオーストリアのウィーンで開催する予定でしたが、新型コロナウイルス感染症の影響でオンライン上での開催となりました。来年こそはウィーンでの開催を予定しています。

プログラム

- 日程: 2020/7/12(日)から18(土) の7日間で以下のようなスケジュールでした。

- 7/12 : Expo Day

- 7/13 : Tutorial and Test-of-Time Award

- 7/14-16 : Main Conference and Invited Talks

- 7/17-18 : Workshops

- Test-of-Time Awardとは、"時の試練に耐えた賞"で10年前のICML論文の中から機械学習の分野に大きな影響を与えたものに与えられる賞で、今回は Gan Process Optimization in the Bandit Setting: No Regret and Experimental Design が受賞しました。

Virtual Conference

今回はオンラインでの開催でした。すべての発表は事前録画されており発表ごとに設けれたウェブサイトから好きなタイミングで視聴することができます。質疑応答はウェブサイト上のチャットを利用するか、発表ごとに決められた時間にZoomでリアルタイムにやり取りすることもできます。質疑の時間は、時差を考慮して各発表あたり2回ずつ設定されていました。世界の研究者の方々と直接交流する機会がないのは残念でしたが、その一方で発表の気になるところを繰り返し視聴できる、発表者交代の時間が必要ない、マルチトラックを気にしなくてもよいなどオンライン開催ならではの利点も感じられました。

投稿数・参加者数

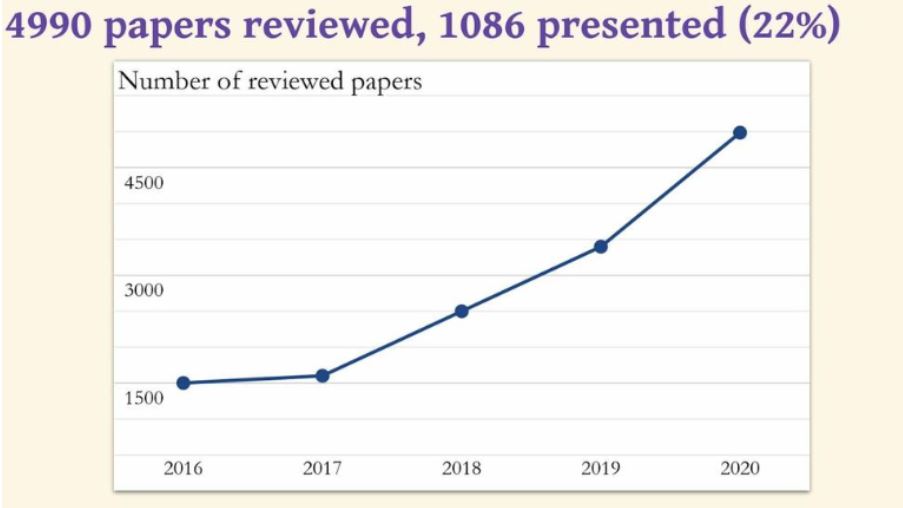

- 今回の投稿数(reviewされたpaper数)は4,490で、採択数が1,086、採択率は21.8%でした。昨年は3,424中774本が採択でした。採択率は昨年とあまり変わりませんが、年々投稿数・採択数が増えています。

- 会議への参加登録者数は全66か国から7,782名(7/10時点)でした。

ICMLでレビューされたpaper数 - [1]の動画より引用

論文紹介

TrajectoryNet: A Dynamic Optimal Transport Network for Modeling Cellular Dynamics

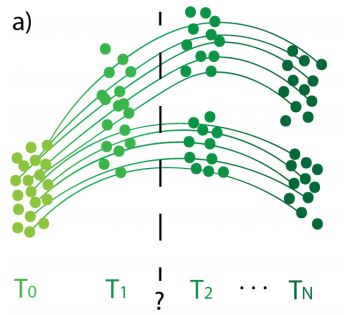

TrajectroyNetは、時間的に離散的な細胞データ(細胞状態を表す高次元データ。具体的には各遺伝子の発現強度を表す数千~数万次元データ)から、データ間の細胞動態を推論するネットワークです。下図のように時刻の細胞のデータが取得できているときにその間の、例えば時刻

と

の間の細胞動態を推論することが目的です。

細胞データの分布の時系列変化のイメージ - [2]Figure 1 a)より引用

人口動態などを推論するのに用いられる Continuous Normalizing Flows (CNFs)に、細胞分裂/死滅、cellular manifold、RNA velocityを考慮した正則化を加えることで既存手法より高精度な推論を可能にしました。

- 細胞分裂/死滅: 個々の輸送経路に分裂率/死滅率を付加

- Cellular manifold: 細胞が存在できる空間は一部に限定される。細胞の密度に関する正則化項を追加。

- RNA velocity: mRNAの痕跡から推定されたデータ取得時の細胞のRNA速度[3]。推定された移動方向に沿うように正則化項を追加。

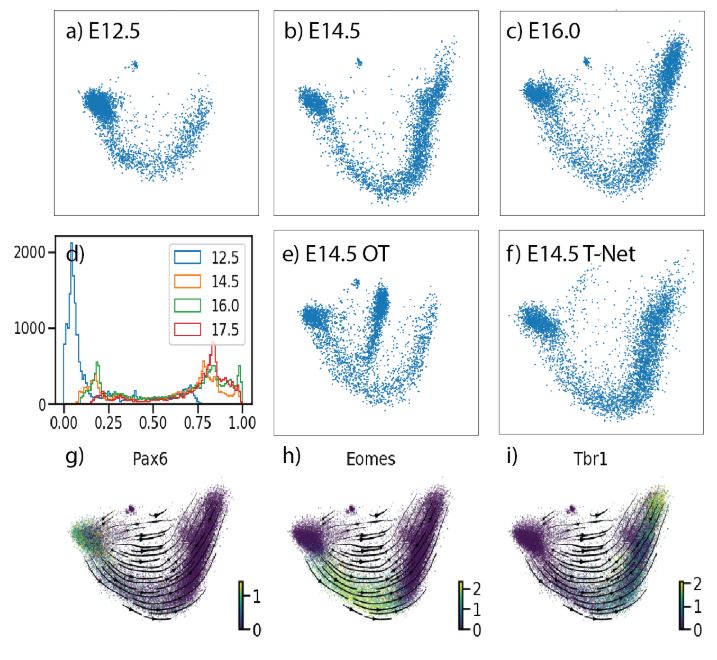

著者らはMouse cortex dataset とEmbryoid body datasetで実験を行い、推定した細胞データの分布と真の分布とをWasserstein metric(EMD)で評価した結果、既存手法より高精度に推定できることを確認しました。下図a), b), c)は時系列順のデータ分布です。a)とc)からその間のb)の分布を推定するというタスクにおいて、e)が既存手法での推定結果、f)が提案手法での推定結果です。両者を比較してみると、e)よりもf)の方が真の分布であるb)に近いことがわかります。なお、 g) h) i) は、神経細胞の分化前期・中期・後期でそれぞれ強発現することが知られているマーカー遺伝子の発現量を図示したもので、提案手法の結果である f) との整合性が高いことを主張しています。

細胞データの分布と推定結果 - [2]Figure 6より引用

分野によっては取得できるデータが限定的になりますが、本研究ではドメイン知識をうまくモデルに取り込むことで推定精度を向上させることに成功しています。

One Size Fits All: Can We Train One Denoiser for All Noise Levels?

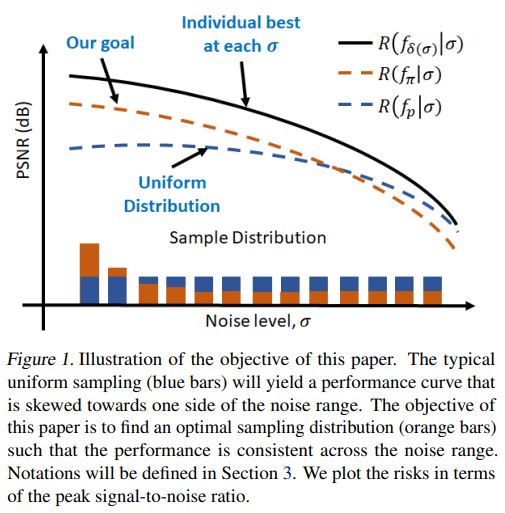

ノイズ除去機(Denoiser)を、ノイズ強度の分布が一様なデータセット(例えば低ノイズ1,000枚、中ノイズ1,000枚、高ノイズ1,000枚)で学習すると高ノイズ画像に対するノイズ除去性能は高い一方で低ノイズ画像に対してはあまり高くないDenoiserになってしまいます。この論文では、どのノイズ強度の画像にも均一な性能になるようなDenoiserを得る手法を提案しています。

学習データのノイズ強度(Noise level)分布とノイズ除去性能(PSNR)の関係- [4]Figure 1より引用

上の Figure 1 はこの論文の目的を説明したものです。黒い実線(Individual best at each )はあるノイズ強度のデータのみで学習し同じノイズ強度の画像で評価した時のPSNR(ピーク信号対雑音比、値が高いほど元画像に近い)のグラフです。一方青い破線(Uniform Distribution)は、ノイズ強度の分布が一様なデータで学習した時の各ノイズ強度の画像に対する性能です。黒線と青破線を比べるとノイズ強度が低いほど両者の性能差が大きくなっています。この論文では、オレンジ色破線(Our goal)のように破線がどのノイズ強度でも黒線から同程度の差になるように学習することを目指します。

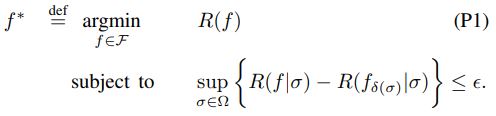

一つ目の手法は、(P1)のような最適化問題を解く手法です。

最適化問題 P1 - [4]より引用

以下の繰り返しアルゴリズムで解を求めます。解法を端的に説明すると性能が足りていないノイズ強度の画像の割合を増やして再学習することを繰り返す方法です。

1.学習データでDenoiserを学習する。

2.学習したDenoiserを各画像のノイズ強度がわかっているテスト画像セットで評価する。

3.評価の結果、性能が目標からより離れているノイズ強度

の割合が増えるように学習データを更新する。

4.更新した学習データで再学習する。

2~4を収束するまで繰り返す。

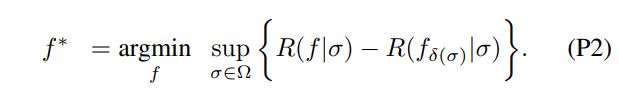

二つ目の手法は、(P2)のような最適化問題を解く方法です。こちらは(P1)と異なり双対分解して解くことができます。

最適化問題 P2 - [4]より引用

著者らはDNNのモデルで両手法を比較し、どちらの手法も所望の性能のDenoiserを得られることを確認しました。ただし、一つ目の手法はあらかじめテストデータの画像のノイズ強度を把握しておく必要があり、また繰り返し学習する際の初期分布に依存します。

学習データに偏りがあると性能に偏りが出てしまうことは有名ですが、学習データが一様であっても性能が一様とは限らないということを本論文で認識しました。本論文ではDenoiserを例としていましたが、Denoiser以外のモデルでも注意が必要です。

Tuning-free Plug-and-Play Proximal Algorithm for Inverse Imaging Problems

最後に紹介するのは、ICML 2020でOutstnading Paperに選ばれた論文です。

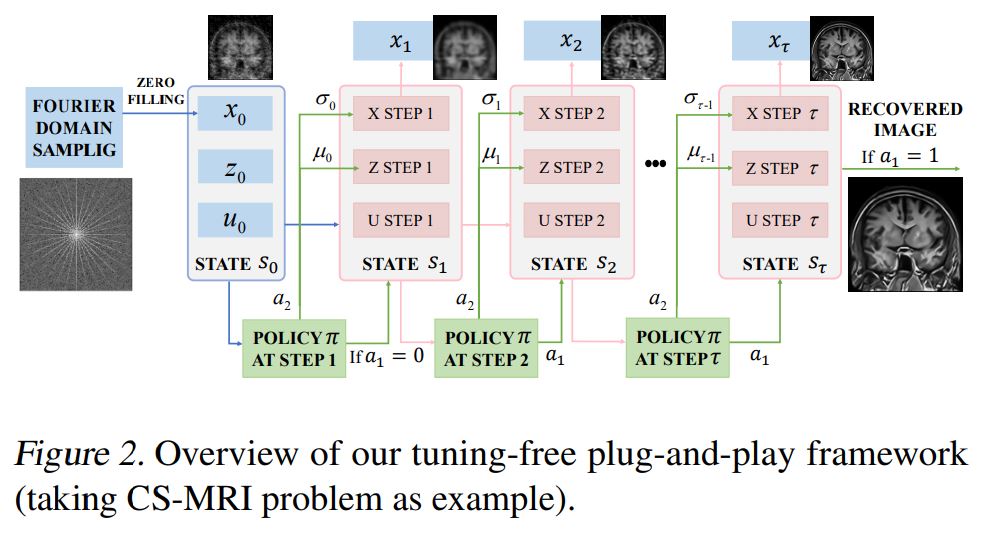

Plug-and-play ADMM (PnP ADMM)という最適化手法があり、経験的に大きな成功を収めていますが、PnPには手動でパラメータを微調整する必要があります。本論文ではパラメータの探索を強化学習のフレームワークに落とし込むことで自動化することに成功しました。

PnPについては本ブログでも過去に紹介しています。詳しくはこちらの記事をご覧ください。(本記事とは文字の定義が異なるのでご注意ください。)

一般に画像復元タスクは次のように書けます。

が損失項で

が正則化項です。ADMMは次のように書けます。

と定義して

パラメータの選択をAction、

をState、(復元結果のPSNR増分-非終了ペナルティ)の減衰累積をRewardとして強化学習のフレームワークに落とし込み、パラメータ探索を自動化しました。

Tuning-free plug-and-play frameworkの概観 - [5]Figure 2より引用

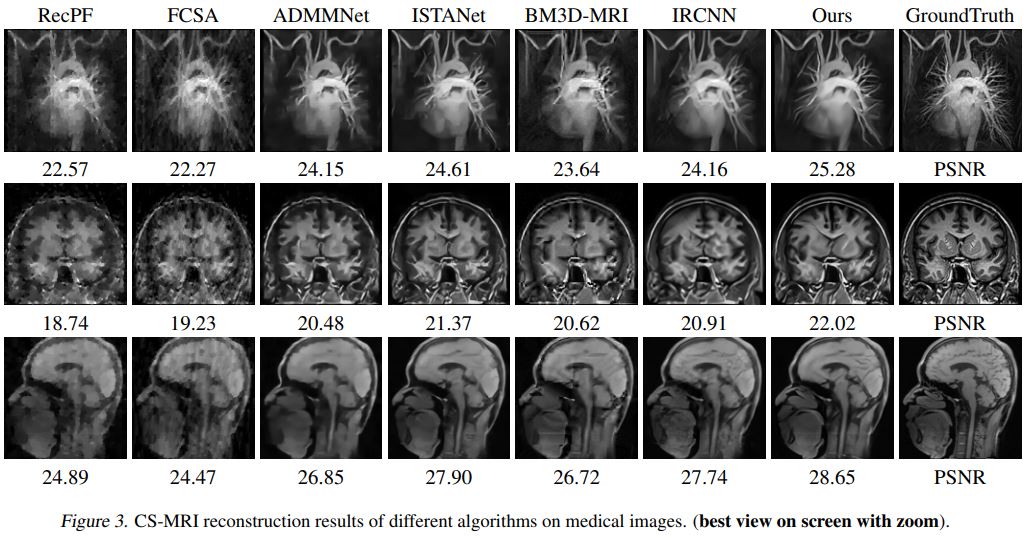

著者らはCompressed Sensing MRIの復元とPhase retrieval の復元タスクで実験を行い、既存手法より優れた結果となることを確認しました。下図は実験結果の一例でCS-MRIの復元結果です。どの画像も既存手法と比べPSNRを0.6以上向上させています。

CS-MRIの復元結果 - [5] Figure 3より引用

後編では「Evaluating Machine Accuracy on ImageNet」等を紹介予定です。